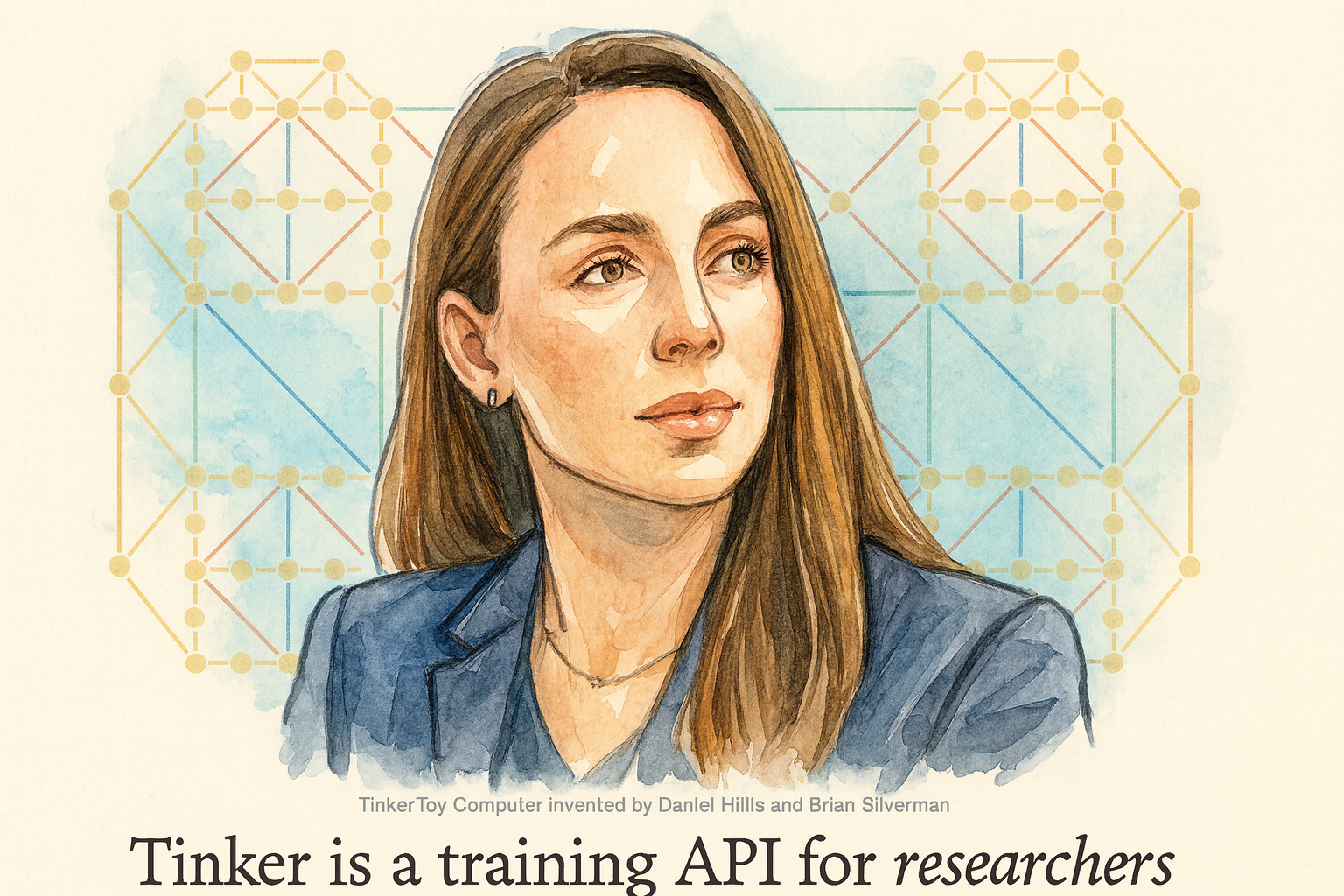

“Tinker” บริการ จากหนึ่งในผู้สร้าง ChatGPT จากดราม่าในอดีต สู่ผู้บริหารหญิง สุดแกร่ง

ท่ามกลางความดุเดือดของการแข่งขันด้าน Ai ของผู้เล่นยักษ์ใหญ่ทั้ง อเมริกัน ยุโรปและจีน ที่ฟาดฟันกันทั้งในส่วนของฟีเจอร์ต่าง ๆ ที่เพิ่มความสามารถในตลอดปี 2025 นี้ และในครึ่งปีหลังของปี 2025 ในที่สุด สาวแกร่งอดีตผู้บริหาร openAI ที่ออกจากสนามไปเงียบ ๆ หลังจากเหตุการณ์ดราม่าใน openAI ก็กลับมาสู่เกมส์อีกครั้ง

Tinker API โผล่มาอย่างเงียบเชียบแต่ทรงพลัง จาก Thinking Machines Lab สตาร์ทอัพที่เพิ่งเปิดตัวผลิตภัณฑ์ตัวแรกเมื่อวานนี้ (1 ตุลาคม 2568) มันคือ API สำหรับ fine-tune โมเดลภาษาขนาดยักษ์ (LLMs) ที่ใช้โค้ด Python ธรรมดาๆ เหมือนเขียนโปรแกรมเล่นๆ แต่เบื้องหลัง Tinker จัดการ GPU กระจายตัวและโครงสร้างพื้นฐานทั้งหมดให้เอง โดยไม่ต้องเสียเงินฟรีในเฟส private beta ตอนนี้ คิดดูสิว่า จากที่เคยต้องเช่าเซิร์ฟเวอร์แพงหูฉี่หรือรอคิวจากคลาวด์ยักษ์ Tinker ทำให้คุณควบคุมทุกขั้นตอนการฝึกโมเดลได้ละเอียดยิบ ตั้งแต่ supervised fine-tuning ไปจนถึง reinforcement learning แบบ multi-agent ราวกับมีผู้ช่วยอัจฉริยะคอยทำเรื่องยากๆทางวิศวกรรม แล้วปล่อยให้สมองคุณโฟกัสที่ไอเดียเจ๋งๆ อย่างการสร้าง AI เชี่ยวชาญคณิตศาสตร์หรือเคมีโดยเฉพาะ

ทางเทคนิค Tinker แตกต่างจากคู่แข่งอย่าง OpenAI's fine-tuning service ตรงที่ไม่ใช่ "กล่องดำ" ลึกลับที่โยนข้อมูลเข้าไปแล้วรอผลลัพธ์แบบงงๆ แต่เป็น low-level API ที่ user-friendly สุดๆ ให้คุณควบคุม primitives อย่าง forward_backward สำหรับคำนวณ loss function หรือ sample สำหรับสุ่มข้อมูลได้เต็มที่ โดยรองรับ open-weight models ขนาดใหญ่เช่น Qwen-235B-A22B (โมเดล mixture-of-experts ที่มีพารามิเตอร์มหาศาลแต่ active แค่ส่วนน้อย ประหยัดพลังงานลงครึ่งหนึ่ง) จุดเด่นคือ ประหยัด GPU ลง 90% ด้วยเทคนิค และจากที่ WIRED สัมภาษณ์ beta testers พวกเขาบอกว่ามัน powerful กว่า tools อื่นๆ ที่มักติดขัดเรื่อง scalability สุดท้าย ผลกระทบต่อไปนี้น่าจะเป็นการเติบโตแบบก้าวกระโดดของวงการวิทยาศาสตร์

นักวิจัยจาก Stanford หรือ Princeton จะ fine-tune AI ได้เร็วขึ้น ปลอดภัยขึ้น สร้างชุมชนการพัฒนาที่กระจายตัว แทนที่จะรวมศูนย์ที่ยักษ์ใหญ่ จนอาจทำให้โมเดลแบบปิด(closed models) อย่าง GPT ต้องปรับตัวแข่งขัน หรืออย่างที่ VentureBeat ชี้ มันกำลังจุดประกาย "การปฏิวัติ fine-tuning" ที่ทุกคนเข้าถึงได้จริง

ทีนี้มาดูทีละประเด็นที่ทำให้ Tinker ไม่ใช่แค่ API ธรรมดา มาจากสมองของ Mira Murati CEO และผู้ก่อตั้ง วัย 36 ปี สาวอิตาลี-แอลเบเนียที่เคยปั้น GPT-4, DALL-E และ ChatGPT จน OpenAI กลายเป็นตำนาน ก่อนลาออกกะทันหันเมื่อกันยายน 2567 หลังดราม่ายุบทีม superalignment (ทีมวิจัยความปลอดภัย AI ที่เธอช่วยดูแล ซึ่งถูกวิจารณ์ว่าถูกกลบโดยแรงกดดันจากบอร์ดบริหาร) เธอชวน John Schulman Co-founder และ Chief Scientist ผู้ก่อตั้ง OpenAI ตั้งแต่ 2558 ชายที่คิดค้น PPO (Proximal Policy Optimization: อัลกอริทึม reinforcement learning ที่ทำให้ AI เรียนรู้แบบ stepwise มีเสถียรภาพ ไม่หลุดราง—หัวใจของ ChatGPT เลยล่ะ) และ Barret Zoph Co-founder อีกคน ในฐานะ CTO ผู้เชี่ยวชาญ multimodal models อย่าง GPT-4o ที่เคยเป็น VP Research ของ OpenAI พวกเขาสามคนนี้รวมทีม 50 คนจาก OpenAI veterans ก่อตั้ง Thinking Machines Lab เมื่อกุมภาพันธ์ 2568 ด้วยทุนก้อนโต 2 พันล้านดอลลาร์ จาก a16z, NVIDIA และ Accel จน valuation พุ่ง 12 พันล้าน

บทความโดย : Geek Consult

เกร็ดย่อย:

MoE เปรียบ Ai เหมือนทีมฟุตบอลที่มีตัวสำรองหมุนเวียน ไม่ต้องให้ Ai ทุกคนลงสนามพร้อมกัน

LoRA (Low-Rank Adaptation: วิธีอัพเกรดโมเดลโดยเพิ่มพารามิเตอร์แค่นิดเดียว ไม่ต้องฝึกใหม่ทั้งกอง)

Update : 04/10/2025

หน้าหลัก (Main) |

(สินค้า IT) ออกใหม่ |

|

FOLLOW US |